CẤU HÌNH PC TRAINING

MACHINE LEARNING / DEEP LEARNING

Có nhiều loại ứng dụng Học máy và Trí tuệ nhân tạo – từ mô hình hồi quy truyền thống, bộ phân loại mạng phi thần kinh và mô hình thống kê được thể hiện bằng các khả năng trong Python SciKit Learn và ngôn ngữ R, cho đến các mô hình Deep Learning sử dụng các frameworks như PyTorch và TensorFlow . Trong các loại mô hình ML/AI khác nhau này cũng có thể có sự đa dạng đáng kể. Phần cứng “tốt nhất” sẽ tuân theo một số yêu cầu tiêu chuẩn, nhưng ứng dụng cụ thể của bạn sử dụng có thể có những yêu cầu tối ưu riêng.

Các đề xuất của chúng tôi sẽ dựa trên những điểm chung từ các quy trình công việc điển hình. Xin lưu ý rằng phần này tập trung vào phần cứng máy trạm ML/DL để “Training” mô hình lập trình thay vì “inference” ( Suy Luận ).

1 - CPU (BỘ XỬ LÝ TRUNG TÂM)

Trong domain Machine Learning / Deep Learning, khả năng tăng tốc GPU chiếm ưu điểm tuyệt đối về hiệu năng trong hầu hết các tác vụ làm việc. Tuy nhiên, CPU và Mainboard sẽ xác định nền tảng để hỗ trợ điều đó. Ngoài ra còn có một thực tế là phải tốn rất nhiều công sức vào việc phân tích và dữ liệu để chuẩn bị cho việc training về GPU và điều này thường được thực hiện trên CPU. CPU cũng có thể là công cụ tính toán chính khi các giới hạn về GPU như tính khả dụng của bộ nhớ trên bo mạch (VRAM) yêu cầu nó.

CPU nào tốt nhất cho Machine Learning/ Deep Learning?

Hai nền tảng CPU được khuyên dùng là Intel Xeon W và AMD Threadripper Pro. Điều này là do cả hai đều mang lại độ tin cậy tuyệt vời, có thể cung cấp các lane PCI-Express cần thiết cho nhiều card màn hình (GPU) và mang lại hiệu năng bộ nhớ tuyệt vời trong không gian CPU. Chúng tôi thường khuyên dùng các máy trạm sử dụng Single CPU để giảm bớt các vấn đề về mapping (ánh xạ) bộ nhớ trên các kết nối chạy dual hoặc quad CPU vốn có thể gây ra sự cố khi mapping (ánh xạ) bộ nhớ tới GPU.

Nhiều nhân thực CPU hơn có giúp PC Workstation training Machine Learning/ Deep Learning?

Số lượng nhân thực được chọn sẽ phụ thuộc vào dữ liệu được dự kiến load lên cho các tác vụ không sử dụng tới GPU. Theo nguyên tắc chung, nên sử dụng ít nhất 4 nhân cho mỗi bộ tăng tốc GPU. Tuy nhiên, nếu khối lượng công việc của bạn có thành phần tính toán CPU nhiều thì 32 hoặc thậm chí 64 nhân thực được coi là lý tưởng. Trong mọi trường hợp, bộ xử lý 16 nhân thường được coi là tối thiểu đối với loại máy workstation này.

Machine Learning/ Deep Learning hoạt động tốt hơn với CPU Intel hay AMD?

Giữa 2 hãng này thì sựa lựa chọn chủ yếu là do sở thích của bạn, ít nhất là nếu khối lượng công việc của bạn bị chi phối bởi khả năng tăng tốc GPU. Tuy nhiên, nền tảng Intel sẽ phù hợp hơn nếu quy trình làm việc của bạn có thể hưởng lợi từ một số công cụ trong Bộ công cụ phân tích AI Intel oneAPI .

Tại sao CPU Xeon hoặc Threadripper Pro được khuyên dùng thay vì các CPU phổ thông hơn?

Lý do quan trọng nhất cho lời khuyên này với khối lượng công việc ML & AI là số lane PCI-Express mà các CPU này hỗ trợ, điều này sẽ quyết định số lượng GPU có thể được sử dụng. Cả Intel Xeon W-3300 và AMD Threadripper PRO 7000 Series đều hỗ trợ đủ lane PCIe cho ba hoặc bốn GPU (tùy thuộc vào cách bố trí bo mạch chủ, không gian của vỏ case và mức tiêu thụ điện năng). Những dòng CPU hi-end này cũng hỗ trợ 8 khe cắm RAM, điều này có thể có tác động rất lớn đến hiệu năng đối với khối lượng công việc liên quan đến CPU. Một điểm cần cân nhắc khác là những bộ xử lý này thuộc về nền tảng enterprise và có khả năng chịu tải liên tục.

2 - GPU (CARD ĐỒ HỌA)

Kể từ giữa những năm 2010, khả năng tăng tốc GPU đã là động lực thúc đẩy những tiến bộ nhanh chóng trong lĩnh vực Machine Learning / Deep Learning và nghiên cứu AI. Để đào tạo Machine Learning / Deep Learning, GPU đã mang lại những cải tiến hiệu năng đáng kể và mạnh hơn so với CPU.

Loại GPU (card màn hình) nào tốt nhất cho Machine Learning / Deep Learning và AI?

NVIDIA thống trị về khả năng tăng tốc tính toán GPU và chắc chắn đó là tiêu chuẩn hiện tại cho Card đồ họa dùng cho Machine Learing / Deep Learning nói riêng và AI nói chung. GPU của NVIDIA sẽ được hỗ trợ nhiều nhất và dễ làm việc nhất. Có những GPU khác có tiềm năng, chẳng hạn như một số GPU AMD cao cấp, FPGA từ nhiều nhà sản xuất khác nhau và các bộ xử lý ML mới nổi khác – nhưng tính khả dụng và khả năng sử dụng của chúng tại thời điểm này chưa đủ để chúng tôi không thể đề xuất chúng.

GPU nào được khuyên dùng cho ML và AI??

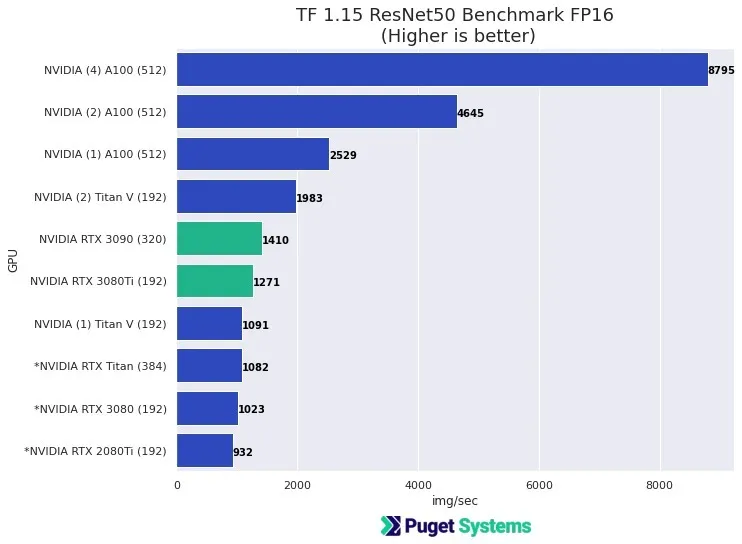

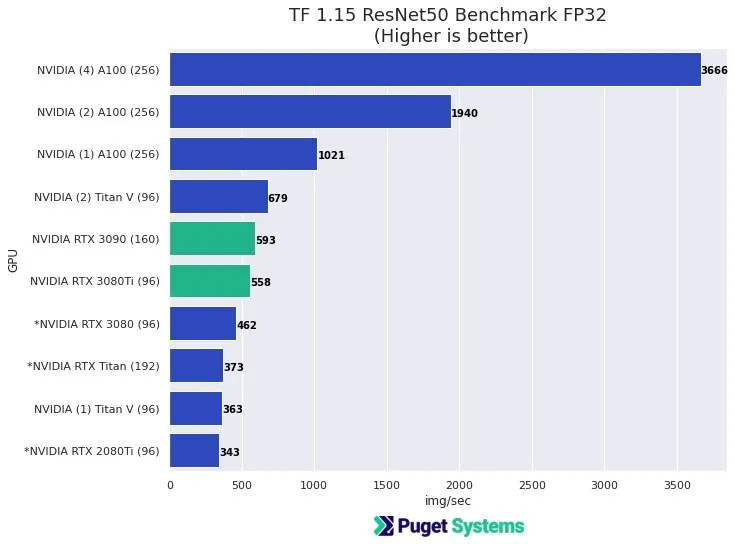

Hầu như bất kỳ card đồ họa NVIDIA nào cũng sẽ hoạt động tốt với ML và AI, với các GPU mới hơn và cao cấp hơn thường mang lại hiệu năng tốt hơn. May mắn thay, hầu hết các ứng dụng ML/AI có khả năng tăng tốc GPU đều hoạt động tốt với độ chính xác đơn (FP32). Trong nhiều trường hợp, việc sử dụng nhân Tensor (FP16) với độ chính xác hỗn hợp sẽ cung cấp đủ độ chính xác cho việc Training model deep learning và mang lại hiệu năng tăng đáng kể so với FP32 “tiêu chuẩn”. Hầu hết các GPU NVIDIA gần đây đều có khả năng này, ngoại trừ các card đời thấp.

Các card đồ họa dành cho người dùng phổ thông như GeForce RTX 4080 / 5080 – 4090 / 5090 của NVIDIA cho hiệu năng rất tốt nhưng lại khó có thể kết hợp nhiều GPU lại với nhau trong cùng một hệ thống máy vì kích thước quá khổ và hệ thống tản nhiệt của chúng không cho phép xếp chồng quá nhiều GPU lên nhau. Các GPU NVIDIA Quadro như RTX A5000 và A6000 có chất lượng cao, có nhiều VRAM hơn và hoạt động tốt trong những bộ máy lắp nhiều GPU. Đặc biệt, RTX A6000 với 48GB VRAM được khuyên dùng để làm việc với dữ liệu có “kích thước tính năng lớn” chẳng hạn như hình ảnh có độ phân giải cao hơn, hình ảnh 3D, v.v.

ML và AI cần bao nhiêu VRAM (bộ nhớ GPU)?

Điều này phụ thuộc vào “feature space” của quá trình model training. Dung lượng bộ nhớ trên GPU đã bị hạn chế và các model hay framework của ML bị hạn chế bởi VRAM có sẵn. Đây là lý do tại sao việc “làm gọn và nén dữ liệu” trước khi training là điều thường được xử lý ưu tiên. Ví dụ: hình ảnh cho dữ liệu training thường có độ phân giải thấp do số lượng pixel nếu để độ phân giải cao sẽ có dung lượng rất nặng và chiếm hết bộ nhớ VRAM. Tuy nhiên, lĩnh vực này đã phát triển rất thành công bất chấp những hạn chế này! Bộ nhớ 8GB cho mỗi GPU được coi là tối thiểu và chắc chắn là sẽ có nhiều hạn chế đối với một số ứng dụng cần nhiều VRAM hơn. 12GB đến 24GB được trang bị trên các dòng GPU cao cấp hơn trong mảng GPU phổ thông như 4070SUPER,4080 hay 4090. Đối với các Project có lượng dữ liệu lớn, 48GB có sẵn trên NVIDIA RTX A6000 có thể là yêu cầu bắt buộc – nhưng thông thường nó không cần thiết.

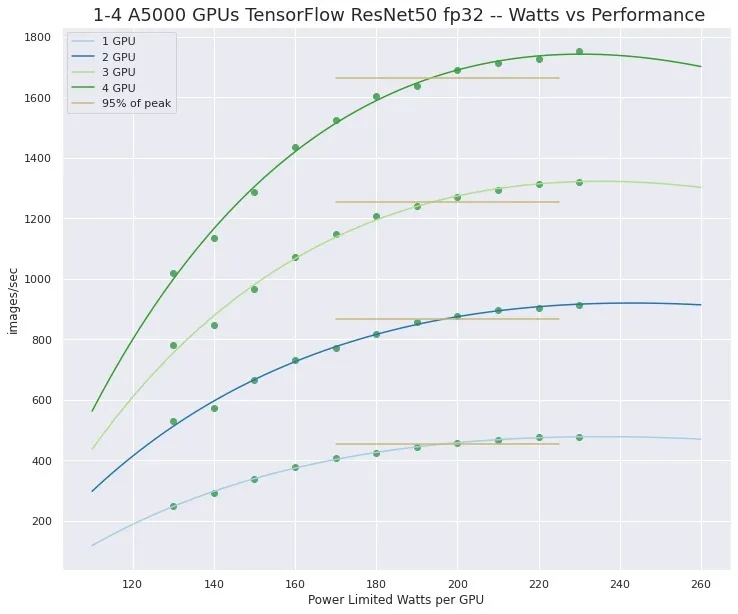

Nhiều GPU có cải thiện hiệu năng trong ML và AI không?

Nói chung là có. Chúng tôi mặc định sử dụng nhiều GPU trong cùng một cấu hình của mình nhưng hiệu năng mà việc này mang lại có thể bị hạn chế. Khả năng tăng hiệu năng của việc gắn nhiều GPU phải được hỗ trợ trong Framework hoặc chương trình đang được sử dụng. May mắn thay, hỗ trợ nhiều GPU hiện đã phổ biến trong các ứng dụng ML và AI – nhưng nếu công việc hiện bạn đang làm mà không được hỗ trợ từ các Framework mới hiện nay thì điều này có thể không cần thiết.

Ngoài ra, hãy nhớ rằng một GPU như NVIDIA RTX 4090 / 5090 hoặc Quadro A5000 / 6000 Ada có thể mang lại hiệu năng rất lớn và có thể đủ sức để đáp ứng cho công việc của bạn. Việc có 2, 3 hoặc thậm chí 4 GPU trong một máy trạm workstation có thể cung cấp khả năng tính toán đáng kinh ngạc và thậm chí có thể đảm bảo hiệu năng cho các project cực lớn. Bạn cũng nên có ít nhất hai GPU khi thực hiện công việc development để cho phép thử nghiệm và mở rộng quy mô nhiều GPU – ngay cả khi các công việc về production sẽ được chuyển sang các cụm điện toán GPU riêng biệt.

ML và AI chạy tốt hơn trên NVIDIA hay AMD?

Có một số công việc đang được thực hiện để làm cho GPU AMD có thể sử dụng được trong lĩnh vực này và Intel sẽ sớm tham gia vào lĩnh vực này, nhưng trên thực tế, NVIDIA đã thống trị và có hơn một thập kỷ nghiên cứu và phát triển thành công, mạnh mẽ đằng sau GPU dành cho máy tính.

ML và AI có cần card màn hình “Quadro” không?

Không. NVIDIA GeForce RTX 4000 – 5000 Series như 5080 16GB, 5090 32GB là những GPU tuyệt vời cho loại khối lượng công việc này. Tuy nhiên, do hạn chế về khả năng làm mát và kích thước, dòng RTX A5000 pro và A6000 / RTX 5000, 5880 Ada có VRAM cao là tốt nhất cho cấu hình máy có ba hoặc bốn GPU. Trong lịch sử, Machine Learning /Deep Learning hiện nay được phát triển trên GPU chơi game NVIDIA và chúng vẫn rất phổ biến cho các máy trạm. Đối với khối lượng công việc đòi hỏi khắt khe nhất, GPU điện toán NVIDIA A100 /H100 là tốt nhất và có thể được sử dụng trong cấu hình rackmount . Chúng rất đắt tiền nhưng hiệu năng thì tuyệt vời ( Những hệ thống này khá chuyên biệt và không sẵn ở Việt Nam)

3 - RAM (BỘ NHỚ TẠM)

Dung lượng RAM bạn cần sẽ phụ thuộc vào project cụ thể của bạn và liệu bạn có thực hiện các tác vụ đòi hỏi nhiều RAM như building lightning hay không.

Machine Learning/ Deep Learning cần bao nhiêu RAM?

Với phần mềm Unreal Engine PC79 khuyên bạn nên chọn ít nhất 32GB RAM cho hầu hết người dùng và 64GB + RAM nếu bạn làm về Building Lightning nặng và tốn nhiều thời gian.

Ngoài ta, nếu bạn thường xuyên làm việc với các chương trình khác ngoài Unreal Engine cùng lúc, bạn có thể muốn có nhiều RAM hơn trong hệ thống của mình vì mỗi chương trình sẽ cần một phần RAM riêng.

Hy vọng thông qua những tư vấn cấu hình PC làm Machine Learning/ Deep Learning có thể giúp bạn có cái nhìn tổng quan hơn và đưa ra những lựa chọn sáng suốt khi sắm cho mình một bộ PC chất lượng. Nếu cần giải đáp bất cứ thắc mắc nào hãy liên hệ trực tiếp với PC79 Store qua Hotline: 0868 792 992 để được tư vấn rõ hơn.