1 - CPU (BỘ XỬ LÝ TRUNG TÂM)

Đối với các máy trạm dành cho LLMs, bạn không cần quá quan tâm tới mã CPU chính xác mà bạn cần quan tâm tới nền tảng của những CPU này, bởi vì LLMs phụ thuộc rất nhiều vào RAM, tốc độ xử lý và cả Lane PCIe Express, Nó sẽ tốt nhất với những nền tảng CPU hỗ trợ 8 channel RAM và Nhiều Lane PCIe Express do đó để lựa chọn chính xác CPU cho LLMs chúng tôi nghĩ bạn nên quan tâm tới các nền tảng AMD EPYC, INTEL XEON hoặc với mức kinh phí thấp hơn bạn cũng có thể lựa chọn nền tảng THREADRIPPER PRO của AMD nó cũng cung cấp cho bạn 8 channel Ram và số Lane PCIe Express rất lớn.

CPU nào tốt nhất cho LLMs?

Hai nền tảng CPU được chúng tôi khuyên dùng là Xeon W của Intel và Threadripper PRO của AMD. Cả hai đều cho bạn số nhân thực cao, hiệu năng và bộ nhớ đệm cao, số lượng lane PCIe lớn. Cụ thể, phiên bản 32 nhân của bất kỳ nền tảng nào trong số này đều được đề xuất vì khả năng sử dụng và hiệu năng bộ nhớ cân bằng.

Nhiều nhân thực hơn CPU có giúp cho việc bạn làm LLMs nhanh hơn không?

Trừ khi bạn đang chạy LLMs trên CPU, điều này thường không có nhiều tác động tới hiệu năng làm việc, số nhân CPU sẽ không có nhiều tác động ngoài yêu cầu đơn giản là với mỗi GPU được lắp trong hệ thống sẽ cần 1 nhân thực CPU.

Tuy nhiên, khi nhu cầu làm việc của bạn liên quan đến nhiều thứ hơn là chỉ chạy các mô hình Generative, CPU có thể có tác động lớn. Ví dụ, nếu một phần quy trình làm việc của bạn liên quan đến việc thu thập, thao tác hoặc xử lý trước dữ liệu, CPU có thể là một thành phần quan trọng trong quy trình làm việc của bạn.

Các luồng dữ liệu, bao gồm thu thập, xử lý trước, phân tích cú pháp ban đầu, tạo nhúng và lưu trữ vector, có thể được chạy trên CPU để tránh quá tải và gây nghẽn cho GPU. Trong trường hợp này, CPU sẽ đóng vai trò khá quan trọng.

LLMs sẽ hoạt động tốt hơn với CPU Intel hay AMD?

Như chúng tôi đã phân tích ở trên thì AMD hay INTEL đều hoạt động tốt, tùy vào kinh phí của bạn và nhu cầu làm việc của bạn.

2 - GPU (CARD ĐỒ HỌA)

Các ứng dụng hiện tại sử dụng cho LLMs đều hoạt động và chạy chính trên GPU, và đây cũng chính là sức mạnh chính của hệ thống trong những vấn đề tính toán này.

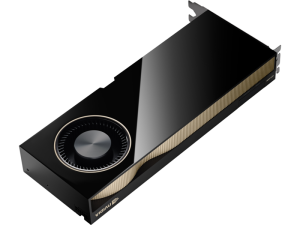

Loại GPU (card màn hình) nào tốt nhất cho LLMs

Đối với các bộ máy làm việc trên LLMs, GPU được dán nhãn “Professional” hoặc “Compute” được chúng tôi khuyên dùng. Điều này là do nó có nhiều VRAM hơn và một phần là vì thiết kế tản lồng sốc thổi gió ra sau của những mẫu GPU này khiến chúng rất thích hợp để lắp nhiều VGA nằm chồng lên nhau trong một bộ máy. Ví dụ như GPU RTX 6000 Ada, L40S và H100 của NVIDIA – hoặc AMD MII Instinct.

LLMs cần bao nhiêu VRAM (bộ nhớ video)?

Khi làm việc với LLMs, tổng VRAM là yếu tố chính quyết định số lượng phép tính toán và cũng chính là giới hạn của bộ máy. Ví dụ, để phục vụ mô hình tham số STOTA ~70b ở độ chính xác gốc của nó gần 200GB VRAM. Ví dụ, Llama3-70b có thể đáp ứng hiệu năng khá tốt trong môi trường nhiều người dùng (tổ chức vừa/nhỏ) với việc bạn gắn 4 x 6000 GPU Ada hoặc 4 x L40s.

Nhiều GPU có cải thiện hiệu năng trong quá trình làm việc của LLMs không?

Như chúng tôi đã phân tích ở trên thì hệ thống máy tính làm việc LLMs rất cần sức mạnh của GPU và VRAM của GPU cho nên nó sẽ tận dụng rất tốt Multi GPU và với các hệ thống máy chạy hệ điều hành Linux sử dụng 4-8 GPU sẽ là chuẩn.

GPU của INVIDIA hay AMD sẽ tốt hơn cho LLMs ?

Chúng tôi vẫn khuyến nghị khách hàng sử dụng INVIDIA bởi vì lịch sử phát triển của INVIDIA rất tốt là luôn luôn dẫn đầu trong lĩnh vực Ai và họ luôn được các nhà phát triển phần mềm support, tuy AMD gần đây đã phát triển lên rất nhiều nhưng chúng tôi vẫn không đánh giá cao các mẫu GPU của họ trong làm việc.

3 - RAM (BỘ NHỚ TẠM)

Dung lượng RAM bạn cần sẽ phụ thuộc vào project cụ thể của bạn và liệu bạn có thực hiện các tác vụ đòi hỏi nhiều RAM như building lightning hay không.

INVIDIA Họ khuyến nghị rằng bạn nên có ít nhất dung lượng RAM gấp đôi dung lượng VRAM mà bạn đang có để đảm bảo có đủ khoảng trống cho CPU hoạt động một cách mượt mà nhất trong quá trình truyền tải dữ liệu.

Ví dụ đơn giản là nếu hệ thống của bạn sử dụng 4 x GPU RTX A6000 ADA 48G bạn sẽ có tổng dung lượng VRAM là : 4×48 = 192GB VRAM. Vậy bạn sẽ cần dung lượng RAM tối thiểu để ổn định hệ thống sẽ là 192×2 = 384GB RAM.

4 - Ổ CỨNG (BỘ NHỚ TẠM)

Yêu cầu lưu trữ tương tự như yêu cầu bộ nhớ CPU. Dữ liệu và dự án của bạn sẽ đưa ra các yêu cầu.

Về LLMs thì càng nhiều dung lượng lưu trữ càng tốt nếu có điều kiện thì bao nhiêu cũng là không đủ vì LLMs mô hình và dữ liệu nạp vào rất nhiều nên yêu cầu về dung lượng lưu trữ là rất lớn.

Chúng tôi khuyến khích bạn có thể sử dụng ổ cứng NVME dòng xịn từ 2TB-8TB.

SUGGEST SYSTEM :

AMD THREADRIPPER PRO :

CPU : AMD Threadripper Pro 7975WX trở lên

MAIN : TRX 50 hoặc WRX90 SAGE

RAM : 256GB REG ECC DDR5 CAO HƠN CÀNG TỐT

VGA : RTX A6000 48GB hoặc RTX A6000ADA 48GB / RTX 5090 32GB ( SỐ LƯỢNG TÙY VÀO KINH PHÍ

OS : LINUX – UBUNTU 24.04 LTS 64bit Server.

INTEL XEON W : ( Cấu hình này không có hàng phân phối ở VN nên khá khó mua và chịu rủi ro về bảo hành )

CPU : Intel Xeon W9-3475X

MAIN : WS W790E-SAGE

RAM : 256GB REG ECC DDR5 CAO HƠN CÀNG TỐT

VGA : RTX A6000 48GB hoặc RTX A6000ADA

4GPU LLMs SEVER : ASUS ESC4000A-E12.

CPU : AMD EPYC 9354P

RAM : 384GB DDR5-5600 ECC REG

VGA : RTX A6000 48GB hoặc RTX A6000ADA / INVIDIA L40S 48GB ( x4 )

OS : LINUX – UBUNTU 24.04 LTS 64bit Server.

8GPU LLMs SEVER : ASUS ESC8000A-E12 10G.

CPU : AMD EPYC 9354P x 2

RAM : 768GB DDR5-5600 ECC REG

VGA : RTX A6000 48GB hoặc RTX A6000ADA / INVIDIA L40S 48GB ( x8 )

OS : LINUX – UBUNTU 24.04 LTS 64bit Server.